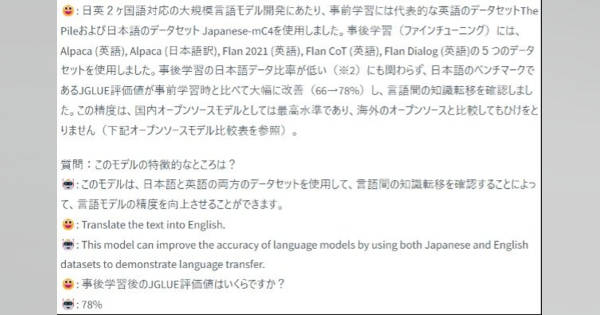

東大松尾研、日英対応の大規模言語モデル公開 100億パラメータ、精度は「国内オープンソース最高水準」

コメント

注目のコメント

松尾研の10Bは是非試したいです!対話モデルもありますね。データセットを明記されたこと、ベンチマークを公表したことが素晴らしいです。ただ、非商用なのが残念。

英語データセットも併せて学習すると、精度が向上することは知られていましたが、これほどとは驚きです。学術界が公開できるのは、商用不可で100億パラメータというのが基準になりますね。

既存の国内オープンソースは、パラメータ数が少ないので、単純比較は難しい。そして、産業界は、自社の競争力を維持しつつ、市場を盛り上げたいので、商用可だけど少ないパラメータ数で公開しがち。

誰がどの精度で商用可/不可で公開するかは、ゲーム理論的な展開になりそうです。パラメータ数競争

世界

1兆2000億 GLaM/Google

1兆850億 PanGu-Σ/Huawai

5400億 PaLM/Google

2800億 Gopher/DeepMind

2600億 Ernie 3.0 Titan/Baidu

1750億 ChatGPT 3/OpenAI

650億 LLaMA/Meta

日本語系

400億 NICT(国立研究開発法人情報通信研究機構)

130億 NEC LLM/NEC

100億 Weblab-10B/松尾研

68億 OpenCALM/サイバーエージェント

36億 Rinna-3.6B/Rinna

36億 japanese-large-lm/LINE

パラメータ数だけで評価はできないですね。アーキテクチャわコーパス数も大事。