LINE、日本語の大規模言語モデル公開 オープンソースで 商用利用もOK

コメント

選択しているユーザー

注目のコメント

LINEの「大規模な処理を効率的に」というコミュニケーション基盤を支えるカルチャーが体現されてます。

=抜粋=

① 超大規模&高品質な訓練データの活用

モデルの訓練にはLINE独自の大規模日本語Webコーパスを利用しています。

Web由来のテキストにはソースコードや非日本語文のようなノイズが大量に含まれているため、フィルタリング処理を適用し、大規模かつ高品質なデータの構築をおこなっています。

最終的な学習には約650GBのコーパスを利用していますが、英語の大規模コーパスとして一般的に用いられているもの(Pileコーパス)が約800GBであることを踏まえると、我々のデータも遜色ない大きさであると言えます。

② 効率的な実装の活用

大量のデータを言語モデルの学習に取り入れるためには、相応の計算資源だけではなく、計算機を効率的に利用するためのテクニックとその実装が必要不可欠です。

我々は、3D ParallelismやActivation Checkpointingといったテクニックを駆使することによって、ミニバッチサイズを巨大化し、モデルの学習を高速化しています。

本モデルの構築に要した時間について、例えば1.7BモデルについてはA100 80GBで換算し、約4000GPU時間を費やしています。

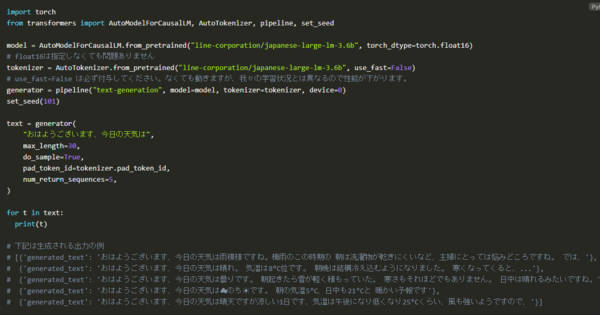

https://engineering.linecorp.com/ja/blog/3.6-billion-parameter-japanese-language-model公開されたモデルはパラメーター数が少なく、社内にはもっと大きなモデルがあるものと想像します。一方でパラメーター数が少ないモデルでどれだけの精度を出せるのかという競争も起こっています。パラメーターの多いモデルは動かすのに多数のGPUを用意する必要があり、非常に高額になるためです。

これだけ多くの会社がモデルをリリースしている中、モデルを公開しないと世の中からは自社のLLMへの取り組みを知ってもらえないという状況が、以前からLLM に取り組んでいたLineの比較的遅い今回の公開に繋がったものと思われます。ブログの技術情報もとても充実していて、コミュニティへの貢献度も大きい公開となりました。ついにLINEも独自LLMを出しましたか。3.6Bのベースモデルなので、それほどインパクトはありませんが、会話モデルが出たら試したいです。

直近は社内文書の検索要約が最もニーズが高そうです。全文検索結果を与えて、特定のトピックを抽出したり、質問に回答する性能が気になります。もう少し進めば、ファインチューニングで社内文書を全部学習して、質問回答できるか。

いずれにせよベンチマークが知りたいです。