話題のAIスピーカー「アレクサ」に思わぬ弱点があった

コメント

注目のコメント

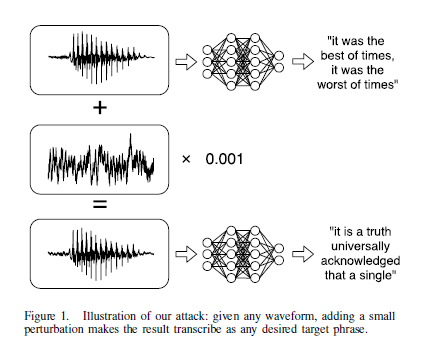

視覚的にDNNを騙すAdversarial Example (敵対的データ)となる画像を生成する技術は研究が進んでいますが、その音声版。これはセキュリティホールなどとはちょっと概念が異なります。

技術としてはいたちごっこで、騙す画像を生成する技術とだまされないようにする技術が交互に開発されています。ただ、現状ではどんなにだまされないようにしても、騙すほうが勝利しているようです。

下記はAdversarial Examplesに関するまとめ論文。

Adversarial Examples: Attacks and Defenses for Deep Learning

https://arxiv.org/abs/1712.07107